Hier sind wir also bei der Planetenfotografie angelangt, oder besser gesagt bei der Planetenvideografie. Die notwendigen Vorbereitungen sind getroffen, das heißt, die Optik ist aufgestellt und ausgerichtet und wurde gegebenenfalls justiert. Der Fokus wurde an einem hellen Stern eingestellt oder bei Zeit- und/oder Lustmangel am anvisierten Planeten selbst.

Der nächste Schritt besteht dann darin, ein Video des betreffenden Planeten aufzunehmen, aber auch hier gibt es ein paar Dinge zu beachten. Es gibt mehrere Programme, die diese Aufgabe gut übernehmen können. Welches davon man verwendet, hängt vom „Look&Feel“ ab. Es schadet nicht, mehrere Programme auszuprobieren, um zu gucken, mit welchem man am besten zurechtkommt. Dieses Video wurde mit dem Programm EZ Planetary aufgenommen. Alternativen sind zum Beispiel Firecapture oder Sharpcap.

Equipment in diesem Fall ((*)=Affiliatelinks – Wir erhalten Provisionen für Einkäufe, die über diese Links in diesem Beitrag getätigt werden.):

- Skywatcher Teleskop N 250/1200 PDS Explorer BD OTA (*)

- Skywatcher Montierung EQ6-R Pro SynScan GoTo (*) oder bei Amazon (*) (Nachfolger der verwendeten NEQ6)

- TeleVue Barlowlinse 2,5x Powermate 1,25″ (*)

- QHY Kamera 5L-IIc Color (*)

Ein allgemeiner Tipp lautet RAW-Modus. Wenn es sich um eine Farbplanetenkamera handelt wie in diesem Fall, dann kann das Programm ein Farbvideo oder ein Video mit Rohdaten (RAW) aufnehmen. Letzteres ist empfehlenswert, weil es die Performance der Kamera erheblich steigert. Die zu übertragenen Daten entsprechen nur einem Drittel der Datenmenge eines Farbvideos, was wesentlich höhere Bildraten erlaubt. Höhere Bildraten bedeuten, dass man mit größerer Wahrscheinlichkeit auch mehr Bilder aufnimmt, bei denen die Luft verhältnismäßig ruhig ist.

Das unten eingebundene Video wurde im RAW-Modus aufgenommen. Man erkennt die Bayermatrix des Kamerasensors, die im Farbmodus für den Farbeindruck des aufgenommenen Objekts zuständig ist. Für Youtube wurde das Video allerdings stark komprimiert. Das Rohdatenvideo ist 2,27GB groß und wurde hier auf wenige MB heruntergerechnet. Die störenden Auswirkungen der unruhigen Luft sind aber trotzdem zu sehen – die Luft wabert und verwischt viele Details in der Atmosphäre Jupiters, zum Beispiel den Großen Roten Fleck.

Video-Link: https://youtu.be/5zMQyzRmwj8

Jupiter wandert im Verlauf des Videos ein Stück nach links. Das wirkt sich nicht negativ auf die Bildqualität aus, sofern die Bewegung langsam und flüssig ist. Lediglich der sichtbare Ausschnitt des resultierenden Bildes ist entsprechend kleiner. Möchte man einen möglichst großen Bildausschnitt haben, etwa für Jupiter mit seinen Monden, dann ist es von Vorteil, wenn Jupiter sich kaum bewegt und im aufgenommenen Video an Ort und Stelle bleibt.

Der erste Schritt ist also getan. Wir haben ein unkomprimiertes Rohdatenvideo aufgenommen. Wie geht es jetzt weiter?

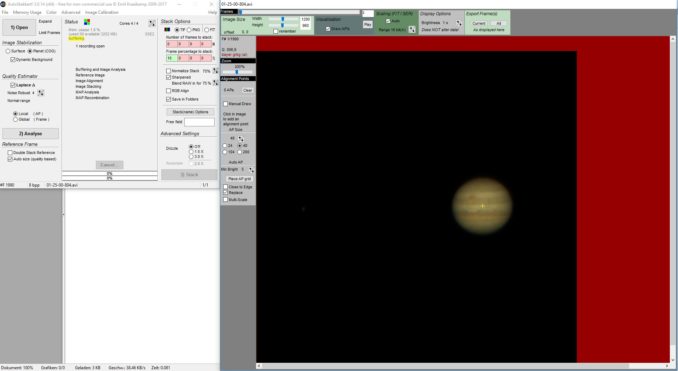

Der nächste Schritt besteht darin, dieses Video im Stackprogramm zu öffnen. Es gibt mehrere Programme, die dafür geeignet sind, beispielsweise Registax, Autostakkert oder Avistack. Ich verwende für dieses Tutorial das Programm Autostakkert. Nach dem Öffnen des Videos ergibt sich (ungefähr) folgendes Bild.

Oben: Das Video wurde in Autostakkert geöffnet. Dem erfahrenen Beobachter wird auffallen, dass das Jupiterbild quasi auf dem Kopf steht, denn der Große Rote Fleck befindet sich eigentlich südlich des Äquators. Das liegt ganz einfach daran, wie die Kamera bei der Aufnahme im Okularauszug steckt. Man kann die Kamera so drehen, dass Jupiter in seiner korrekten Ausrichtung zu sehen ist. Man kann das Video aber auch so aufnehmen und das Ergebnis des Stackingprozesses im Rahmen der Bildbearbeitung später um 180 Grad drehen.

Außerdem sind hier im Gegensatz zum aufgenommenen RAW-Video Farbinformationen zu sehen, was darauf zurückzuführen ist, dass Autostakkert die Rohdaten automatisch debayert. Oben im Menüpunkt „Color“ kann man einstellen, ob Autostakkert die Bayermatrix automatisch erkennen soll, oder ob es eine bestimmte nutzen soll. Nicht alle Kameras verwenden die gleiche Bayermatrix.

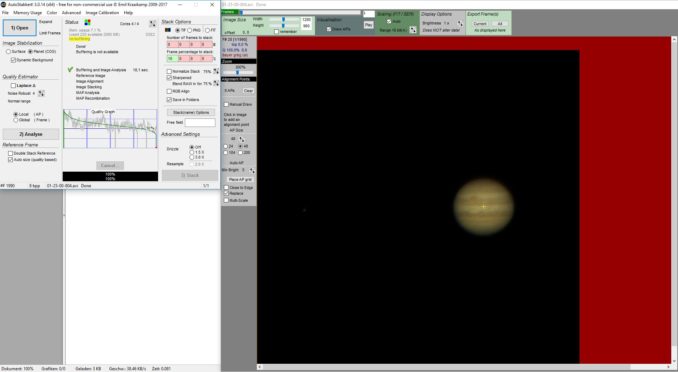

Die roten Flächen im rechten Fenster kennzeichnen den Versatz der Videodaten, der durch die Bewegung der Bildinhalte selbst hervorgerufen wird: Je ruhiger das Objekt während der Videoaufnahme in der Bildmitte verharrt, desto kleiner werden die roten Flächen ausfallen. Wie oben erwähnt, verschlechtert das nicht die Bildqualität, solange es eine langsame und flüssige Bewegung ist. Mit Hilfe der beiden kleinen Schieberegler oben im rechten Fenster kann man das Bild auf den tatsächlich sichtbaren Teil zurechtschneiden. Der Stackingprozess wird dadurch etwas schneller. Ändert man nichts an der Bildgröße, wird das Bild so gestacked, wobei die roten Flächen im Endergebnis nicht zu sehen sind.

Wichtig sind die Einstellungen im linken Fenster auf der linken Seite. Da es sich um einen Planeten handelt, muss die Einstellung „Planet“ ausgewählt werden. Der „Dynamic Background“ ist aktiviert, weil der Versatz in diesem Beispiel relativ groß war. Das Häkchen bei „Laplace“ wird entfernt, weil die „Noise Robust“-Einstellung darunter auf 4 steht und sich diese Einstellung erst ab einem Wert von 6 positiv auswirkt. Außerdem soll die Einstellung „Local (AP)“ berücksichtigt werden. Nach der Auswahl aller Option startet ein Klick auf „Analyse“ die Qualitätsanalyse des Videos. Das Ergebnis der Analyse sieht so aus:

Nach der Analyse hätte man noch einmal die Möglichkeit, den Bildausschnitt, der tatsächlich gestacked wird, mittels der Schieberelger zu verkleinern. Im linken Fenster ist das Ergebnis der Analye zu sehen. Die grüne Linie stellt den Qualitätsverlauf aller Frames im analyiserten Video dar, angefangen bei den besten (links) bis hin zu den schlechtesten Einzelframes (rechts). Die senkrechten Striche dienen der Orientierung und kennzeichnen jeweils 25 Prozent, 50 Prozent und 75 Prozent der Frames. Die mittlere horizontale Linie markert die qualitative 50-Prozent-Grenze.

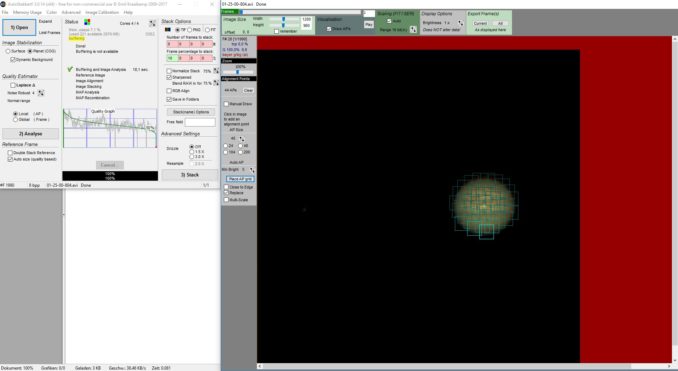

Damit Autostakkert die Auswirkungen der Luftunruhe berücksichtigen kann, müssen mehrere Ausrichtungspunkte (Alignment Points) auf dem Objekt platziert werden. Das kann man manuell machen, aber auch automatisch. Hier habe ich eine Größe von 40 Pixeln gewählt und die Punkte mit einem Klick auf „Place AP grid“ automatisch setzen lassen (siehe unten).

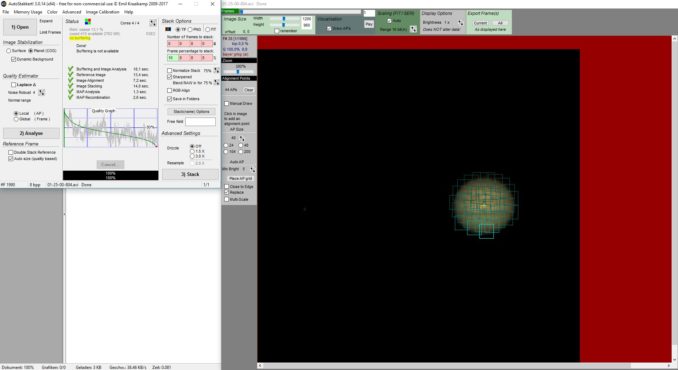

Jetzt geht es um die Anzahl der zu stackenden Einzelframes. Man kann guten Gewissens alle Frames stacken, die oberhalb der oberen waagerechten Linie stehen, also der 75-Prozent-Qualitätslinie. Man kann auch weniger stacken (hier sind es 10 Prozent, wie oben rechts zu sehen ist) – oder mehr. Mit ein bisschen Herumprobieren gelangt man zu verschiedenen Ergebnissen und erkennt, welche Einstellungen besser waren. Eine pauschale optimale Einstellung dafür gibt es nicht, weil eben die Qualität der Videos stark schwankt. Auf Drizzle und Resample verzichte ich im Allgemeinen. Nach dem Klick auf „Stack“ werden die Bilder gemäß der ausgewählten Parameter übereinandergelegt. Das Ergebnis sieht so aus:

Die grünen Häkchen in der Mitte des linken Fensters sagen aus, dass der Stackingprozess erfolgreich war und das Ergebnisbild im entsprechenden Ordner gespeichert wurde. Das gespeicherte Bild ohne weitere Bildbearbeitung sieht so aus (Anklicken zum Vergrößern):

Das war das Stacking – aber das war noch längst nicht alles. Nach dem Stacking folgt die eigentliche Bildbearbeitung, die man mit jedem guten Bildbearbeitungsprogramm durchführen kann. Wie eingangs angesprochen, steht das Bild auf dem Kopf. Es wird also um 180 Grad gedreht, damit der Große Rote Fleck da ist, wo er hingehört – auf die Südhalbkugel. Anschließend sucht man sich (gegebenenfalls bei hoher Bildvergrößerung) die hellste Region (das hellste Pixel) aus, die auf Jupiter zu sehen ist und setzt darauf einen Weißpunkt (Einstellungen der Gradationskurven). Damit erhält Jupiter annähernd seine natürliche Farbgebung.

Nun kann man die einzelnen Farblayer zurechtrücken, falls starke rote und blaue Farbsäume den Bildeindruck stören. Der letzte Schritt besteht im Schärfen des Bildes. Hier gibt es so viele verschiedene Schärfungsfilter, dass man selbst ausprobieren muss, welcher die augenscheinlich besten Ergebnisse liefert. Gerade das Schärfen ist sehr vom subjektiven Empfinden des Betrachters abhängig. Man sollte es nur nicht übertreiben – tauchen nach dem Schärfen Artefakte im Bild auf, war es zuviel des Guten.

Das endgültige Resultat nach der Bearbeitung sieht dann so aus (Anklicken zum Vergrößern, hier auf Flickr):

Ich möchte noch einmal betonen, dass dies nur eine von vielen möglichen Vorgehensweisen ist. Das Tutorial dient nur als grobe Richtlinie, mit der akzeptable Ergebnisse erzielt werden können. Jeder interessierte Planetenbeobachter beziehungsweise Planetenfotograf wird darauf aufbauen können und schließlich seinen eigenen „Workflow“ entwickeln. Ich hoffe, das Lesen (und Nachmachen) hat trotzdem Spaß gemacht und für ein paar AHA-Effekte gesorgt.

supi erklärt bravo thomas