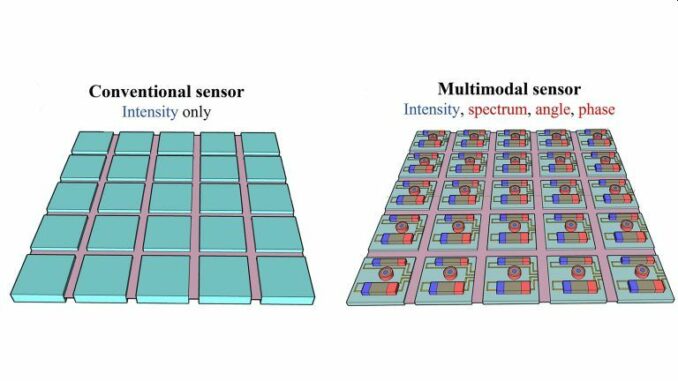

Bildsensoren messen die Lichtintensität, aber der Winkel, das Spektrum und andere Aspekte des Lichts müssen ebenfalls ausgelesen werden, um das maschinelle Sehen entscheidend zu verbessern.

Im Journal Applied Physics Letters, herausgegeben von AIP Publishing, stellen Forscher der University of Wisconsin in Madison, der Washington University in St. Louis und von OmniVision Technologies die neuesten Nanostrukturkomponenten auf Bildsensorchips vor, die wahrscheinlich den stärksten Einfluss auf die multimodale Bildgebung haben.

Die Entwicklungen könnten autonomem Fahrzeugen ermöglichen, um die Ecke zu sehen, anstatt nur geradeaus. Biomedizinische Bildverfahren könnten Abnormalitäten in unterschiedlichen Gewebetiefen erkennen und Teleskope könnten durch interstellaren Staub blicken.

„Bildsensoren werden langsam einen Wandel erfahren, um die idealen künstlichen Augen für Maschinen zu werden“, sagte der Co-Autor Yurui Qu von der University of Wisconsin in Madison. „Eine Entwicklung, die sich die bemerkenswerten Leistungen existierender Bildsensoren zunutze macht, wird wahrscheinlich unmittelbare Auswirkungen haben.“

Bildsensoren, die Licht in elektrische Signale umwandeln, bestehen aus Millionen Pixeln auf einem einzigen Chip. Die Herausforderung besteht darin, multifunktionale Komponenten als Teil des Sensors zu miniaturisieren und zu kombinieren.

In ihrer eigenen Arbeit beschreiben die Forscher detailliert einen vielversprechenden Ansatz zur Erstellung von Multibandspektren durch die Herstellung eines On-Chip-Spektrometers. Sie brachten photonische Kristallfilter aus Silizium direkt auf den Pixeln auf, um komplexe Interaktionen zwischen dem einfallenden Licht und dem Sensor zu erschaffen.

Die Pixel zeichnen die Verteilung der Lichtenergie auf, woraus die spektralen Informationen über das Licht abgeleitet werden können. Das Gerät ist weniger als sechs Quadratmillimeter groß und kann programmiert werden, um verschiedene dynamische Bandbreiten, Auflösungen und fast jedes spektrale Band von sichtbarem Licht bis Infrarot zu berücksichtigen.

Die Forscher konstruierten eine Komponente, die Winkelinformationen registriert, um die Tiefe zu messen und 3D-Formen in kleinen Maßstäben zu erstellen. Ihre Arbeit wurde durch richtungsabhängiges Hörvermögen inspiriert, was beispielsweise Geckos besitzen. Die Köpfe von Geckos sind zu klein, so dass sie die Richtung, aus der ein Geräusch kommt, nicht auf dieselbe Art und Weise bestimmen können wie Menschen oder andere Tiere. Stattdessen nutzen sie verbundene Trommelfelle, um die Richtung eines Geräuschs innerhalb eines Bereichs zu lokalisieren, der mehrere Größenordnungen kleiner ist als die entsprechende akustische Wellenlänge.

Auf vergleichbare Weise wurden Paare aus Silizium-Nanodrähten als Resonatoren konstruiert, um die optische Resonanz zu messen. Die in zwei Resonatoren gespeicherte optische Energie hängt vom Einfallswinkel ab. Der Draht, der dem Licht am nächsten ist, schickt den stärksten Strom. Indem man die stärksten und schwächsten Ströme aus beiden Drähten vergleicht, kann der Winkel des eintreffenden Lichts bestimmt werden.

Auf einem Chip mit einem Quadratmillimeter Fläche können Millionen dieser Nanodrähte platziert werden. Die Studie könnte Fortschritte auf den Gebieten der linsenlosen Kameras, augmented Reality und dem automatischen Sehen fördern.

(THK)

Antworten